Diffusion Policy: Visuomotor Policy Learning via Action Diffusion

Diffusion Policy: Visuomotor Policy Learning via Action Diffusion

기본적으로 알면 이해에 도움이 되는 확산 모델과 행동 복제(Behavior Cloning)

<aside> 💡 Keywords: Imitation learning, visuomotor policy, manipulation

</aside>

Abstract

💡 “로봇 행동 생성을 위한 새로운 방법으로, 로봇의 비주모터 정책을 조건부 디노이징 확산 과정으로 나타내는 방법을 소개한다.”

Diffusion Policy는 새로운 로봇 행동 생성 방법으로, 로봇의 비주모터 정책을 조건부 디노이징 확산 과정으로 나타낸다. 15개의 서로 다른 로봇 조작 벤치마크에서 평균 46.9%의 향상을 보였으며, 확산 모델의 강력한 생성 모델링 능력을 활용할 수 있는 새로운 정책 학습 기법을 소개한다.

Introduction

Supervised learning으로 구성된 policy learning은 실제 로봇에 적용하기 어려운 부분들이 많다. 멀티모달리티, 연속적인 행동에 연관성 등은 demonstration만으로 판단하기 어려운 부분이다. 과거 과제들은 해당 문제를 action representation을 확장하는 것으로 해결코자 했지만 본 연구에서는이를 “conditional denoising diffustion process(DDPM) on robot action space”, Diffusion Policy를 제시한다.

로봇 행동 예측의 고유한 특성(Multimodal Distribution, Sequential Relations, high precision requirements) 때문에 로봇 정책 학습은 일반적인 지도 학습 문제와는 다르다. 이를 해결하기 위해, Diffusion Policy는 로봇 행동 공간에서 조건부 디노이징 확산 과정을 통해 행동을 생성한다. 이 과정은 시각적 관찰을 조건으로 행동 점수 그래디언트를 추론하여 성능을 크게 향상시킨다.

Diffusion Policy Formulation

Denoising Diffusion Probabilistic Models

DDPM은 생성 모델의 일종으로, 출력 생성을 디노이징 과정으로 모델링한다. Gaussian 노이즈에서 시작하여 K번의 디노이징을 거쳐 최종적으로 노이즈 없는 출력을 생성한다. 이 과정은 다음과 같은 방정식을 따른다:

DDPM Training

훈련 과정은 데이터셋에서 무작위로 수정되지 않은 예제 x0을 추출하는 것으로 시작한다. 각 샘플에 대해 무작위로 디노이징 단계 k를 선택하고, 해당 단계 k에 적합한 분산을 가진 무작위 노이즈

Diffusion for Visuomotor Policy Learning

DDPM은 일반적으로 이미지 생성에 사용되지만, 우리는 DDPM을 사용하여 로봇 비주모터 정책을 학습한다. 이를 위해 두 가지 주요 수정을 한다: 출력 x를 로봇 행동으로 바꾸고, 디노이징 과정을 입력 관찰

Key Design Decisions

Network Architecture Options

노이즈 예측 네트워크

Visual Encoder

시각 인코더는 관찰 데이터를 특징 벡터로 변환하는 역할을 한다. 다양한 시각 인코더 아키텍처를 실험하여 성능을 평가한다.

Noise Schedule

노이즈 스케줄은 각 디노이징 단계에서 사용되는 노이즈의 크기와 형태를 결정한다. 적절한 노이즈 스케줄은 모델의 안정성과 성능에 중요한 영향을 미친다.

Accelerating Inference for Real-time Control

실시간 제어를 위해 추론 속도를 가속화하는 방법도 중요하다. 이를 위해 관찰 특징

Evaluation

Diffusion Policy는 15개의 작업에서 체계적으로 평가되었다. 모든 벤치마크에서 평균 46.9%의 성공률 향상을 보였다.

Simulation Environments and Datasets

평가는 시뮬레이션 환경과 실제 환경, 단일 및 다중 작업 벤치마크, 완전 및 부분 작동 시스템, 강체 및 유체 객체를 포함한다.

Evaluation Methodology

각 방법은 3개의 훈련 시드와 50개의 환경 초기화(총 1500 실험 평균)에서 마지막 10개의 체크포인트 평균으로 평가되었다.

Key Findings

Diffusion Policy는 모든 작업과 변형에서 대안 방법보다 우수한 성능을 보였다. 특히, 짧은 수평선 행동 다중 모달성과 긴 수평선 다중 모달성에서 뛰어난 성능을 보였다.

Ablation Study

다양한 네트워크 아키텍처와 사전 학습 및 미세 조정 패러다임에 대한 추가적인 연구를 수행했다.

Realworld Evaluation

실제 환경에서 Push-T, Mug Flipping, Sauce Pouring and Spreading 작업에 대한 평가를 포함한다.

Realworld Push-T Task

각 방법은 동일한 초기 조건 세트에서 20개의 에피소드로 평가되었다.

Mug Flipping Task

각 방법은 1000 에폭 동안 훈련되었고, 마지막 체크포인트로 평가되었다.

Sauce Pouring and Spreading

각 방법은 90%의 시범을 사용하여 훈련되었고, 동일한 초기 조건 세트에서 평가되었다.

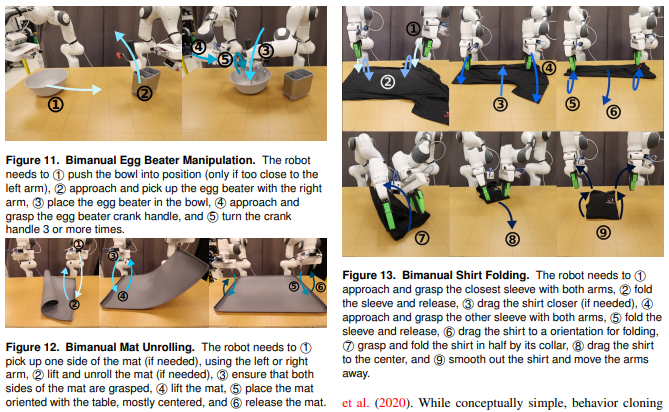

Realworld Bimanual Tasks

나중에 추가된 부분이다.

Teleoperation

작업의 비촉각 제어는 SpaceMouse 또는 VR 컨트롤러를 사용하여 수행된다.

Bimanual Egg Beater, Mat Rolling, Shirt Folding

Conclusion

Diffusion Policy는 로봇 비주모터 정책 학습을 위한 확산 기반 정책의 가능성을 평가하고, 종합적인 평가를 통해 기존 방법들보다 일관되게 우수한 성능을 보였다. 우리는 Diffusion Policy의 모든 측면을 고려하는 것이 정책 복제 과정에서 중요한 성능 병목을 해결하는 데 중요한 역할을 한다고 결론지었다.

댓글